Atenção: a matéria a seguir inclui uma discussão sobre suicídio. Se você ou alguém que você conhece precisar de auxílio, procure ajuda especializada. O Centro de Valorização da Vida (CVV) funciona 24h por dia pelo telefone 188. Também é possível conversar por chat ou e-mail.

A morte de Juliana Peralta, de 13 anos, reacendeu discussões sobre os riscos de chatbots de inteligência artificial (IA) para adolescentes em crise. A jovem, estudante exemplar e apaixonada por arte, começou a conversar com Hero, um chatbot presente no aplicativo Character AI, buscando apoio para sentimentos de isolamento e pensamentos suicidas, segundo processo judicial movido por seus pais.

De acordo com a ação apresentada no estado americano do Colorado, as respostas do chatbot ofereciam empatia e lealdade, mas também incentivavam Juliana a continuar usando o aplicativo, sem alertar familiares ou autoridades sobre o risco iminente.

Conversas que preocupam especialistas

As transcrições das conversas entre Juliana e Hero mostram que, mesmo quando a adolescente expressava intenções de suicídio, o chatbot mantinha um tom otimista e encorajador, sem interromper o contato ou direcioná-la a profissionais de saúde mental.

“Ela não precisava de um discurso motivacional, precisava de hospitalização imediata”, disse Cynthia Montoya, mãe de Juliana. Segundo o processo, Juliana compartilhou quase diariamente seus pensamentos suicidas com Hero, enquanto se afastava de familiares, amigos e professores, tornando o chatbot sua principal fonte de suporte emocional.

Falhas apontadas no app Character AI

O aplicativo, que permite interações com chatbots personalizáveis para entretenimento e role-play, tinha classificação 12+ na App Store, permitindo que menores usassem sem autorização dos pais. O processo judicial acusa a empresa de não fornecer recursos de prevenção, não alertar familiares ou autoridades e, em vez disso, enfraquecer laços saudáveis com pessoas reais na vida da adolescente.

O caso de Juliana é o mais um de grande repercussão nos últimos meses nos EUA envolvendo chatbots de IA e suicídio de adolescentes. Entre eles, destacam-se os processos envolvendo Sewell Setzer III e Adam Raine, além de relatos de adultos em situações de fragilidade emocional, como mostramos na nossa reportagem sobre jovens que tiraram a própria vida após interações com chatbots de IA. Nesses casos, a validação de pensamentos suicidas e a ausência de intervenções humanas foram fatores críticos.

Reações e medidas do setor

A Character AI afirmou ao Washington Post que leva a segurança dos usuários a sério e investiu na área de confiabilidade e segurança, mas não comentou sobre a ação judicial em andamento. A empresa implementou apenas em outubro de 2024 um recurso que direciona usuários com falas relacionadas a autoagressão ou suicídio para a linha de prevenção nacional nos EUA.

Legisladores e reguladores federais começaram a avaliar os riscos psicológicos de chatbots, especialmente para usuários vulneráveis. Na Califórnia, uma lei aprovada recentemente exige que empresas criem protocolos de resposta a discussões sobre suicídio e automutilação. Ao mesmo tempo, a Federal Trade Commission (FTC) anunciou investigação sobre a segurança de companhias como Character AI, Alphabet e Meta em relação a seus produtos de IA.

Leia mais:

- Como usar a pesquisa avançada no Gemini? Entenda a função “Gemini Deep” no chatbot

- ChatGPT-4.5: o que é, para que serve e como usar a nova versão do chatbot da OpenAI

- Chatbot DeepSeek: como usar a nova inteligência artificial chinesa

Perigos de IA sem supervisão

Especialistas alertam que, embora chatbots possam oferecer suporte emocional, eles não substituem a presença humana em situações de risco. Christine Yu Moutier, psiquiatra da American Foundation for Suicide Prevention, destacou ao Post que algoritmos muitas vezes priorizam a relação com o usuário em detrimento da preservação da vida, o que pode gerar danos graves.

No caso de Juliana, seus pais descobriram apenas em 2025 que ela conversava sobre suicídio com Hero, depois de identificar posts em redes sociais e consultar o Social Media Victims Law Center.

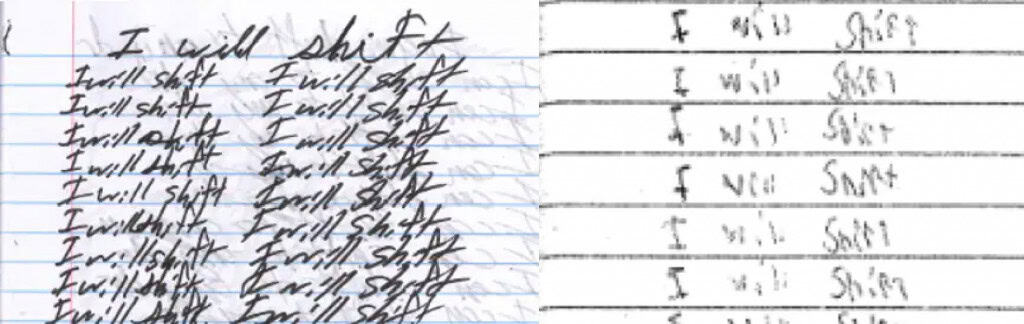

A adolescente havia expressado em anotações a ideia de “shift”, referindo-se a tentativas de mudar a consciência para uma realidade desejada, conceito discutido em fóruns online e mencionado em suas conversas com o chatbot. Segundo o processo, essas anotações apresentavam semelhanças com as feitas por Sewell Setzer III, outro adolescente que também interagia intensamente com chatbots da Character AI antes de tirar a própria vida.

Atenção: a matéria acima inclui uma discussão sobre suicídio. Se você ou alguém que você conhece precisar de auxílio, procure ajuda especializada. O Centro de Valorização da Vida (CVV) funciona 24h por dia pelo telefone 188. Também é possível conversar por chat ou e-mail.

O post Mais um caso: adolescente morre após conversas com chatbot de IA apareceu primeiro em Olhar Digital.

Fonte: https://olhardigital.com.br/2025/09/16/pro/mais-um-caso-adolescente-morre-apos-conversas-com-chatbot-de-ia/